Transparenz und Gute Regierungsführung Tech platform governance: navigating the future of digital (non-)regulation

„Das macht es zu einem besonders relevanten Thema in der Debatte über den Wiederaufbau der Ukraine. Denn russische Desinformationskampagnen nutzen die sozialen Medien gezielt, um beispielsweise das Vertrauen in ukrainische Institutionen zu untergraben oder die Unterstützung des Westens zu schwächen“, erklärt Katharina Lehner vom Sekretariat der Plattform den Teilnehmenden.

Gleichzeitig bewegten sich einige der großen Tech-Plattformen unter dem Banner der Meinungsfreiheit zunehmend in Richtung einer Politik der Nicht-Regulierung.

In der Veranstaltung am 27. Mai 2025, die die Plattform Wiederaufbau Ukraine gemeinsam mit der DW Akademie durchführt, geht es um die Treiber dieses Trends, die damit verbundenen potenziellen Risiken und die Bedeutung für den Wiederaufbauprozess der Ukraine.

Plattformen, Politik und Verantwortung – wie soziale Medien unsere Demokratie herausfordern

Der erste Referent, Ewan Thomas-Colquhoun, beginnt seinen Vortrag. Er setzt die Frage ins Zentrum, wie Plattformen gestaltet sein müssten, um demokratischen Diskurs zu fördern, statt ihn zu gefährden. Denn soziale Netzwerke beeinflussten nicht nur Kommunikation, sondern auch politische Entscheidungen und gesellschaftliche Stimmungen.

Er nennt dazu eindrückliche Zahlen: „Untersuchungen haben ergeben, dass nur drei bis sechs Prozent der Online-Zeit tatsächlich damit verbracht werden, sich mit Nachrichten zu beschäftigen. (…) Die größte Gruppe von Menschen, die das Internet und soziale Medien nutzen, bezeichnen wir als Daily Briefer. Das sind Menschen, die täglich auf die Nachrichten zugreifen, sich aber in der Regel an ein oder zwei größere, etablierte Quellen halten. Diese tendieren eher zu den öffentlich-rechtlichen Sendern, aber auch zu älteren etablierten Medien, Zeitungen und solchen Dingen. (…) Das bedeutet wiederum, dass der Online-Diskurs wirklich von einer Minderheit der Nutzer geprägt wird. Nun gibt es auch Erkenntnisse, dass (…) die wirklich kleinste Gruppe (…) diejenigen sind, die am ehesten in Echokammern zu finden sind. Echokammern sind in der Theorie Orte, (…) in denen sich Menschen nicht mit einer Vielzahl von Ansichten auseinandersetzen, und wir können innerhalb dieser sehr kleinen Gruppe von Menschen oft sehr polarisierte Debatten sehen.“

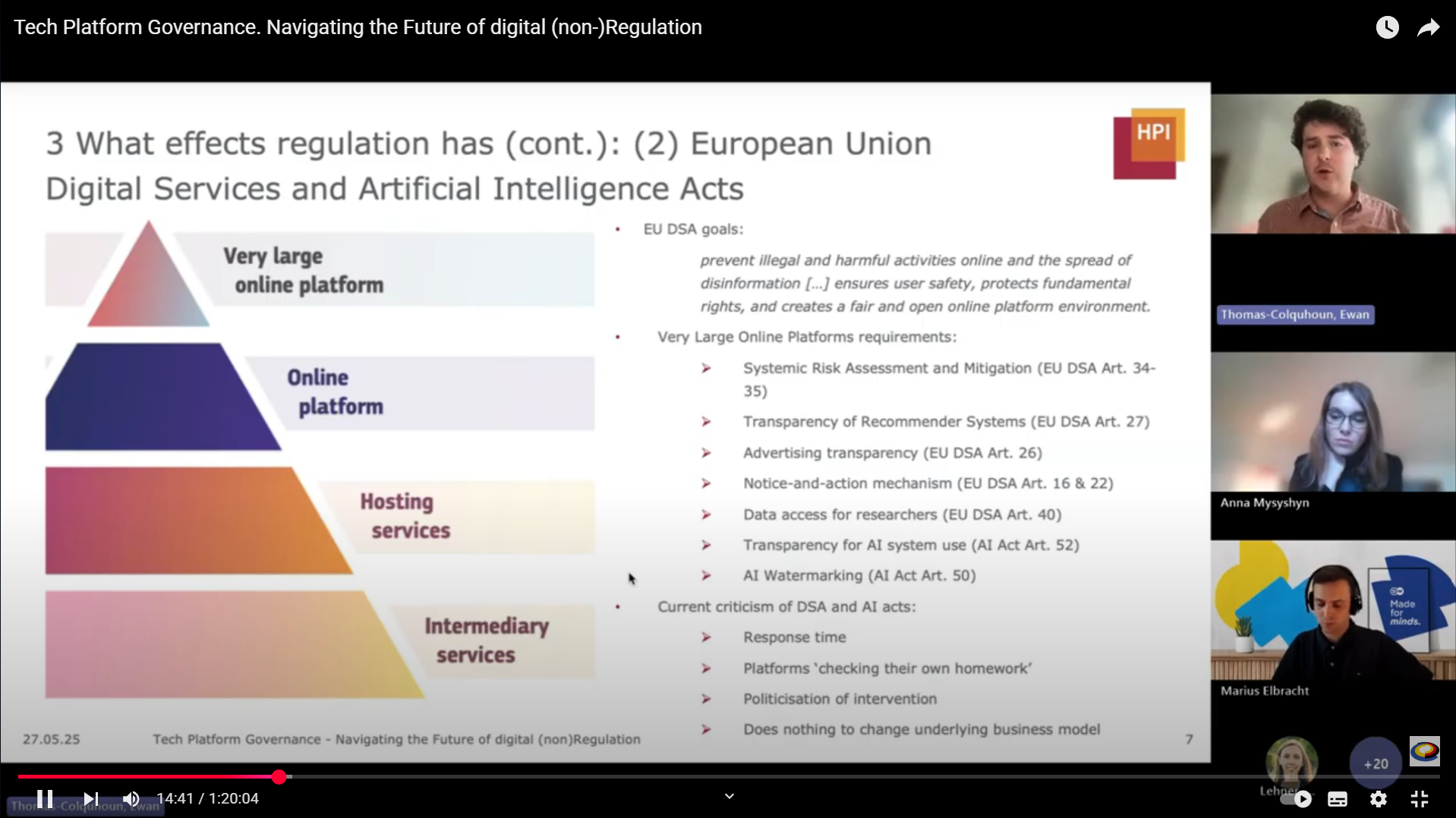

Ewan Thomas-Colquhoun geht auf den EU-weiten Digital Services Act (DSA) ein.

Er hebt hervor, dass der EU-weite Digital Services Act (DSA) einen neuen Standard setzt, insbesondere durch die Transparenzpflichten für Plattformen und die Verpflichtung zur Risikobewertung algorithmischer Systeme:

„Es gibt gerade eine Untersuchung gegen X [vormals Twitter], die die Behauptungen untersucht, dass rechtsextreme Inhalte gefördert werden. (…) Der Bericht ist allerdings noch nicht veröffentlicht. Republikanische Konten erzielten demnach vor der amerikanischen Präsidentschaftswahl mit größerer Wahrscheinlichkeit ein höheres Engagement, nachdem Elon Musk die Plattform übernommen hatte, als demokratische Konten.“

Er erklärt auch, warum die Beeinflussung von Algorithmen in Verbindung mit den eingangs erwähnten Echokammern zu Problemen führen kann:

„Der Algorithmus liefert den Menschen individuellere Inhalte. Wie ich bereits erwähnt habe, gibt es eine gewisse Selbstselektion in diesen eher parteiischen Echokammern, die Hass und Extremismus verstärken und letztendlich zu Gewalt führen können, da es keine wirkliche Kontrolle oder Rechenschaftspflicht für die Inhalte gibt, die die Menschen austauschen.“

Zentral sei zudem, die Verantwortlichkeiten der Plattformen festzuhalten: Sie müssten nicht nur technische Lösungen bieten, sondern auch strukturell verantwortungsvoll handeln. „Plattformen profitieren wirtschaftlich davon, wenn extreme Inhalte geteilt werden – das ist systemimmanent. Es braucht daher klare Regeln und Transparenz darüber, wie Inhalte priorisiert oder moderiert werden.“

Besonders große Plattformen, sogenannte Very Large Online Platforms (VLOPs), unterliegen laut DSA verschärften Anforderungen. Doch die Umsetzung sei nicht einfach, erklärt Ewan Thomas-Colquhoun: „Wir sehen viel Verzögerung. Manche Plattformen kooperieren nur zögerlich. Aber ohne klare Standards läuft jede Selbstregulierung ins Leere.“

Wenn die Plattformen teilweise zu langsam reagierten, was könne – fragt Moderator Marius Elbracht (DW Akademie) denn Experten – jede*r Einzelne*r von uns tun?

Thomas-Colquhoun sieht einige Handlungsmöglichkeiten: Das aktive Melden von Hassrede oder illegalen Inhalten sei zentral, insbesondere über die im DSA vorgesehene Notice-and-Action-Mechanik, die eine schnellere Reaktion durch Behörden ermögliche.

Ebenso betont er: „Es ist wichtig, sich bewusst zu machen, welche Verantwortung man selbst in der Online-Kommunikation trägt – gerade als Unternehmen. Will man wirklich neben 100 Millionen Krypto-Anzeigen erscheinen?“

Gerade Unternehmen sollten sich laut ihm mit der Funktionsweise von Plattformen auseinandersetzen, um strategisch entscheiden zu können, wo sie kommunizieren und wer davon profitiert.

Dr. Anna Mysyshyn warnt eindringlich vor Desinformation durch Deepfakes und KI

Die zweite Referentin in der Veranstaltung, Dr. Anna Mysyshyn, zeigt den Teilnehmenden eindrücklich, wie gefährlich und strategisch Desinformationskampagnen orchestriert werden – sowohl innerhalb der Ukraine als auch mit Blick auf internationale Zielgruppen.

Gleich zu Beginn ihrer Präsentation macht sie die emotionale Schlagkraft von Propagandainhalten deutlich: „Es braucht nur sieben Sekunden auf TikTok, um frisch gestrichene Gebäude im besetzten Mariupol zu zeigen; Kinder, die unter russischer Flagge lachen – das Leben scheint wieder normal. In diesen sieben Sekunden wird die Invasion zur ‚Wiederaufbauhilfe‘ umetikettiert.“

Sie beschreibt damit den Kern der Problematik: „Es gibt eine immer größere Kluft zwischen physischer Realität und einer virtuellen Realität, die gezielt konstruiert wird, um die Wahrheit zu untergraben.“

Russland missbraucht Technologie zur Erstellung zahlreicher Deepfakes.

Ein zentrales Thema ihres Vortrags handelt vom Technologiemissbrauch für die Erstellung von Deepfakes. Mysyshyn nennt konkrete Fälle:

- 2022 tauchte ein manipuliertes Video auf, in dem Präsident Selenskyj angeblich ukrainische Soldaten zur Kapitulation aufruft.

- Ein weiteres Beispiel ist der manipulierte Online-Auftritt des Kyjiwer Bürgermeisters Vitali Klitschko, der mit Hilfe von Stimmklontechnologie europäische Amtskolleg*innen kontaktierte, um vertrauliche Informationen zu erhalten.

- Auch Ex-Generalstabschef Walerij Saluschnyj wurde Ziel solcher Fälschungen, wie auch zahlreiche gefälschte Bilder von angeblichen ukrainischen Soldaten, erstellt mit Tools wie Midjourney oder DALL-E.

„Für Expert*innen ist es leicht zu erkennen, dass es sich um Fakes handelt – aber wir waren überrascht, wie viele Menschen, gerade ältere, diese Inhalte unreflektiert teilen“, warnt sie.

In ihrer Analyse geht Mysyshyn detailliert auf die wichtigsten Social-Media-Plattformen ein:

- Telegram bezeichnet sie als „graue Zone“: Telegram werde sowohl von Zivilisten als auch von offiziellen Stellen in der Ukraine genutzt – das mache es besonders gefährlich für die Verbreitung gefälschter Regierungsinformationen und Propaganda.

- Facebook sei besonders unter der älteren Generation und der Diaspora verbreitet – gerade hier hätten russische Netzwerke über 60 Fake-News-Seiten eingerichtet, um gezielt anti-ukrainische Narrative zu verbreiten.

- TikTok sei wegen seiner emotionalen, unterhaltsamen Inhalte besonders tückisch. Gerade junge Menschen würden hier mit scheinbar harmlosen Inhalten konfrontiert, die russische Soldaten romantisieren oder suggerieren, dass die Ukraine korrupt und zerfallen sei.

- X ( vormals Twitter) sei vollständig unreguliert, mit Fake-Accounts, die durch den blauen Haken legitim erscheinen.

- YouTube werde für längere Propagandainhalte genutzt, zum Beispiel mit Hilfe von russischen sogenannten „Dokumentationen“ über den Donbass. Diese würden durch Künstliche Intelligenz (KI) in bis zu 40 Sprachen übersetzt und gestreut.

Über Hashtags wie #Korruption, #Mobilisierung oder #Selenskyj, so Anna Mysyshyn, werde gezielt das Vertrauen in die ukrainische Regierung untergraben. Die Inhalte zeichneten Militärkommandanten als abgehoben und korrupt, während gleichzeitig das Leben in besetzten Gebieten romantisiert werde. Das Ziel? Die Gesellschaft demoralisieren und spalten.

Besonders alarmierend laut Mysyshyn: „Das Vertrauen in lokale Medien ist von 57 auf 29 Prozent gesunken. Viele Menschen vertrauen Facebook-Posts oder YouTube-Videos mehr als klassischen Medien.“

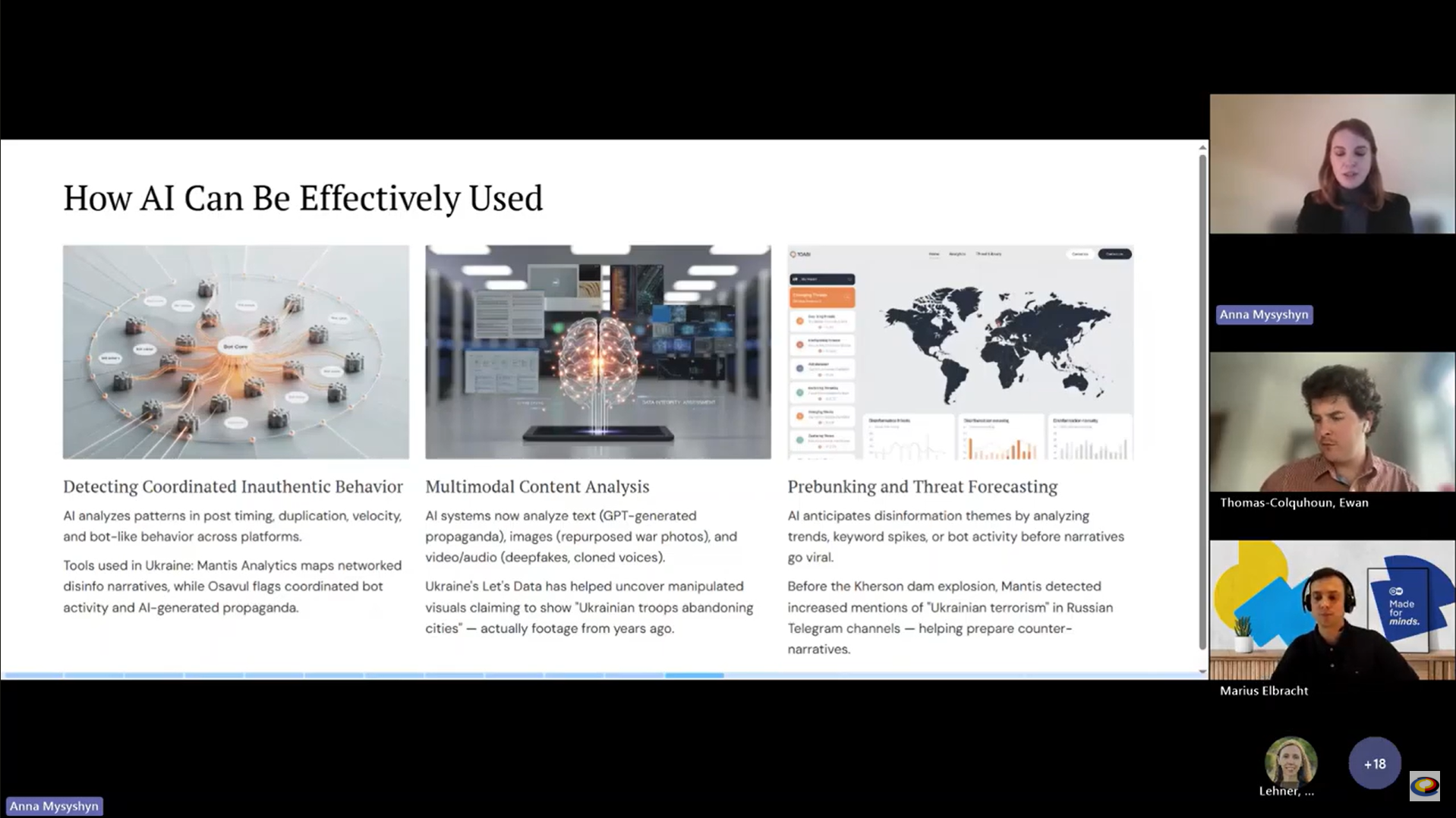

KI kann auch dazu genutzt werden, Desinformation zu bekämpfen.

Sie macht aber deutlich, dass KI nicht nur für die Erzeugung von Desinformation genutzt werde – sie könne auch zu deren Bekämpfung beitragen. Dabei verweist sie auf ukrainische Start-ups wie LetsData (Externer Link), OSAVUL (Externer Link) und Mantis Analytics (Externer Link), die KI-basierte Tools entwickeln, um:

- Narrative und Muster von Desinformation zu erkennen,

- Bot-Netzwerke aufzudecken und

- virale Inhalte frühzeitig zu identifizieren.

„Mit nur 30 Sekunden Audiodaten kann heute jeder ein Deepfake mit Stimmklon erstellen. Auch ich – hier, live – wäre theoretisch in Minuten kopierbar. Das ist beängstigend.“

Was könne demnach eine erfolgreiche Strategie sein? Mysyshyn sieht einen mehrschichtigen Ansatz:

- Human-in-the-Loop-Moderation: „Wir dürfen die Bewertung von Inhalten nicht allein der KI überlassen. Menschen müssen Inhalte überprüfen.“

- Multimodale Analyse: Texte, Bilder, Videos und Audios müssten zusammen bewertet werden.

- Narrative antizipieren und frühzeitig widerlegen: „Bevor Falschnachrichten viral gehen, müssen wir sie entkräften.“

- Kooperation mit Plattformen: Telegram sollte in der App Verifikationen erlauben, ähnlich wie es Brasilien vorgemacht hat.

- Förderung von Medienkompetenz: Faktenchecks und Medienbildung seien essenziell – überall, nicht nur in der Ukraine.

Ihre klare Forderung: „Nur wenn Regierung, Tech-Konzerne, Zivilgesellschaft und Nutzer*innen zusammenarbeiten, können wir etwas erreichen.“ Und Thomas-Colquhoun ergänzt: „Transparenz allein löst keine Probleme – sie ist nur der Anfang.“

Vorangegangene Veranstaltungen

Hier finden Sie vorangegangene Veranstaltungen zum Themenkomplex Desinformation, die gemeinsam von der DW Akademie und der Plattform Wiederaufbau Ukraine durchgeführt worden sind: